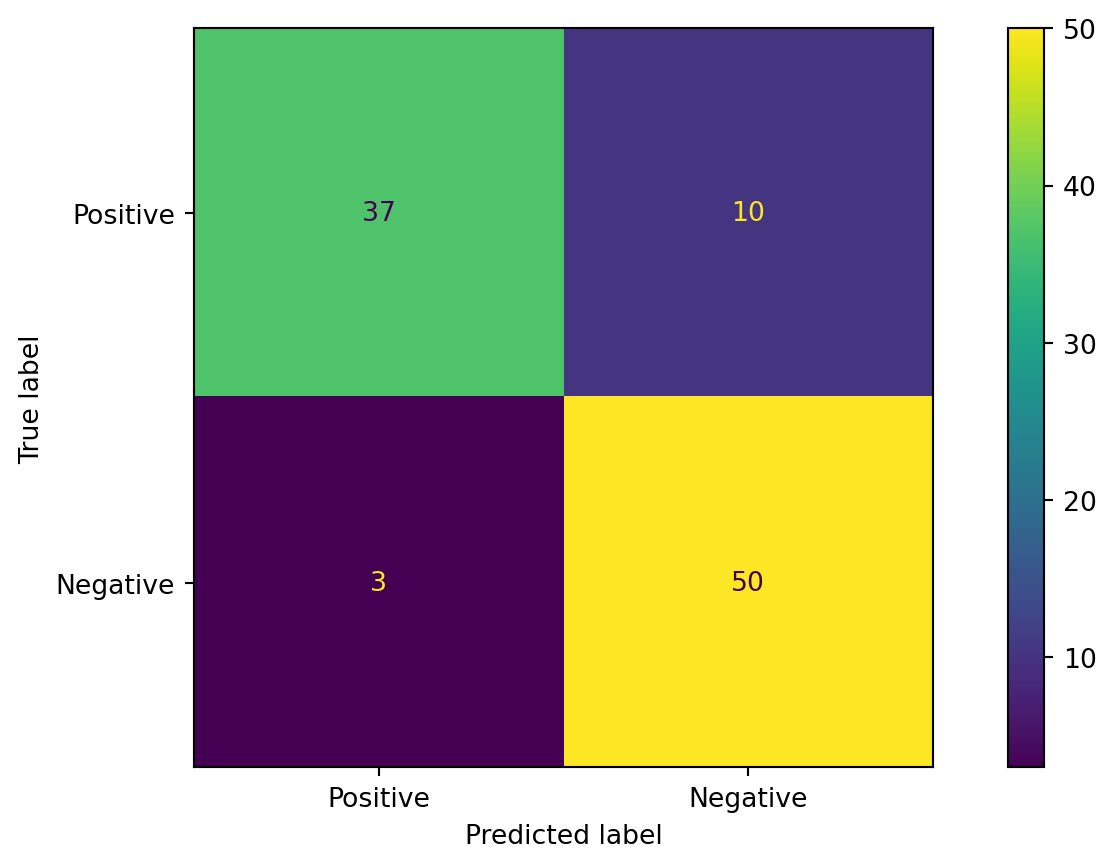

from sklearn.metrics import roc_auc_score

y_pred_prob_lr = lr.predict_proba(X_test)[:, 1]

y_pred_prob_knn = knn.predict_proba(X_test)[:, 1]

y_pred_prob_dt = dt.predict_proba(X_test)[:, 1]

y_pred_prob_rf = rf.predict_proba(X_test)[:, 1]

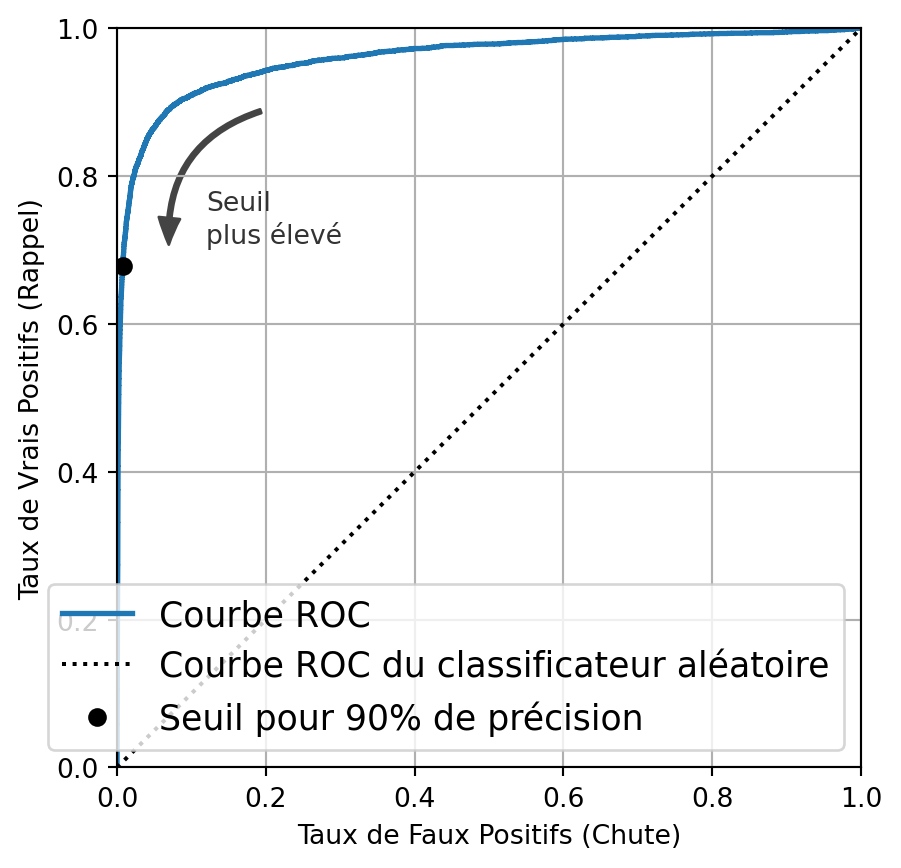

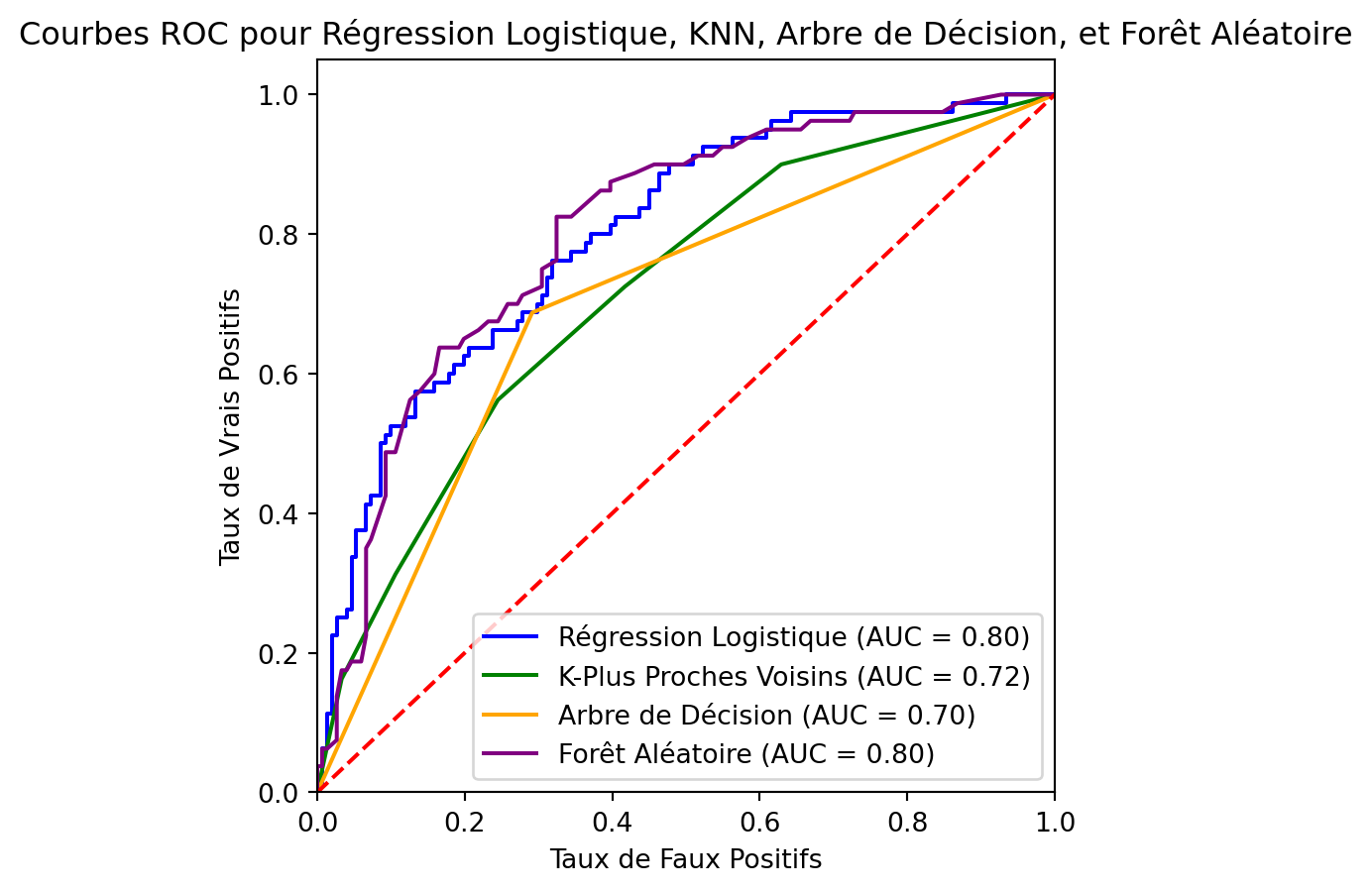

# Calculer les courbes ROC

fpr_lr, tpr_lr, _ = roc_curve(y_test, y_pred_prob_lr)

fpr_knn, tpr_knn, _ = roc_curve(y_test, y_pred_prob_knn)

fpr_dt, tpr_dt, _ = roc_curve(y_test, y_pred_prob_dt)

fpr_rf, tpr_rf, _ = roc_curve(y_test, y_pred_prob_rf)

# Calculer les scores AUC

auc_lr = roc_auc_score(y_test, y_pred_prob_lr)

auc_knn = roc_auc_score(y_test, y_pred_prob_knn)

auc_dt = roc_auc_score(y_test, y_pred_prob_dt)

auc_rf = roc_auc_score(y_test, y_pred_prob_rf)

# Tracer les courbes ROC

plt.figure(figsize=(5, 5)) # plt.figure()

plt.plot(fpr_lr, tpr_lr, color='blue', label=f'Régression Logistique (AUC = {auc_lr:.2f})')

plt.plot(fpr_knn, tpr_knn, color='green', label=f'K-Plus Proches Voisins (AUC = {auc_knn:.2f})')

plt.plot(fpr_dt, tpr_dt, color='orange', label=f'Arbre de Décision (AUC = {auc_dt:.2f})')

plt.plot(fpr_rf, tpr_rf, color='purple', label=f'Forêt Aléatoire (AUC = {auc_rf:.2f})')

plt.plot([0, 1], [0, 1], color='red', linestyle='--') # Ligne diagonale pour le hasard

plt.xlim([0.0, 1.0])

plt.ylim([0.0, 1.05])

plt.xlabel('Taux de Faux Positifs')

plt.ylabel('Taux de Vrais Positifs')

plt.title('Courbes ROC pour Régression Logistique, KNN, Arbre de Décision, et Forêt Aléatoire')

plt.legend(loc="lower right")

plt.show()